Mezzogiorno di Suono - Parte VII

Dei cinque sensi regalatici da Madre Natura, quelli che più cooperano in sinergia tra loro sono indubbiamente vista ed udito...

Dei cinque sensi regalatici da Madre Natura, quelli che più cooperano in sinergia tra loro sono indubbiamente vista ed udito. Raramente si ha un’immagine non accompagnata dal suono, o un suono non collegato ad un’immagine.

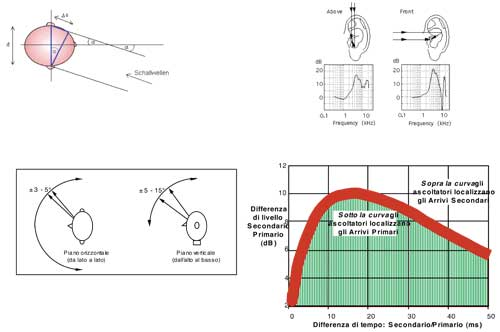

La duplicità degli organi di senso deputati a cogliere le immagini e ascoltare i suoni ci consente una buona localizzazione degli eventi che generano le informazioni visive ed uditive. La stereoscopia dona profondità alle immagini, aiutandoci a valutare la distanza… mentre non possiamo dire altrettanto della stereofonia, un artefatto creato dai ricercatori dei Bell Laboratories negli anni ’30 del secolo scorso, quando si cercò un metodo per riprodurre il suono ricostruendo le caratteristiche spaziali delle sorgenti acustiche disposte lungo un ‘fronte sonoro”. Il metodo usato dal nostro sistema uditivo per localizzare un suono è, in realtà, molto più complicato della stereofonia. Alle frequenze più basse localizziamo il suono nel piano orizzontale (azimutale) in base alla differenza temporale con la quale esso arriva alle nostre due orecchie, lontane tra loro mediamente 17 ÷ 19 cm (Figura 1). Quando il ritardo fra i due segnali percepiti è massimo, la posizione della sorgente è identificata come laterale rispetto all’ascoltatore, alla sua sinistra o alla sua destra a seconda che arrivi per primo il segnale percepito dall’orecchio corrispondente. Alle alte frequenze, oltre i 5 kHz, è il profilo timbrico a provvedere informazioni sulla posizione della sorgente poiché a tali frequenze, l’ingombro del capo pone un serio ostacolo alla propagazione del suono. Ne consegue una forte attenuazione del segnale percepito dall’orecchio più lontano dalla sorgente. Infine, alle frequenze medie – da 1 a 5 kHz – le informazioni sono ricavate da un mix di entrambi i metodi. Da notare, per inciso, che il metodo della differenza temporale (o di fase) non fornisce indicazioni utili al disotto della frequenza di 215 ÷ 225 Hz. Pertanto non siamo in grado di localizzare i suoni gravi (prodotti, ad esempio, dal motore di un autocarro o da un tuono) se non attraverso le loro armoniche. Questa lacuna è ampiamente sfruttata dai sistemi di riproduzione del suono 2.1, composti da due diffusori per i medi e alti ma uno solo per i bassi, capaci ugualmente di generare una convincente immagine spaziale, ancorché con tutte le limitazioni della stereofonia.

E la localizzazione verticale? Questa richiede un meccanismo ancor più complicato che si basa sulle molteplici riflessioni di un’onda sonora in direzione dell’ingresso del condotto uditivo prodotte dalle pieghe dei padiglioni auricolari. Le riflessioni interagiscono tra loro, causando alterazioni della risposta in frequenza (Figura 2). Sono proprio queste alterazioni, attraverso l’esperienza acquisita con l’apprendimento, che ci consentono di valutare con una sufficiente approssimazione l’elevazione di una sorgente sonora.

La qualità dei nostri organi di senso, affinati dall’evoluzione, produce una localizzazione coerente delle immagini e dei suoni associate ad un evento specifico. Poiché la localizzazione uditiva è meno accurata di quella visiva – ha una tolleranza di 3 ÷ 5° in orizzontale e 5 ÷ 15° in verticale (Figura 3) – il nostro cervello è programmato in modo da compensare eventuali discrepanze e privilegiare la localizzazione visiva. Questa capacità di compensazione ha dei limiti straordinariamente ampi: secondo il nazional-revanscista Gabriel, coprotagonista di Codice Swordfish “… quello che l’occhio vede e l’orecchio sente, la mente crede”. Ed è proprio così, anche se pagando un prezzo, chiamato “fatica d’ascolto”. Il tentativo di conciliare immagini e suoni difformi costringe il cervello ad un superlavoro, che l’affatica e riduce progressivamente l’attenzione. Ma la piena attenzione è quanto chiede, anzi esige, un conferenziere o un predicatore dai suoi ascoltatori, quale compenso per la sua fatica. Per questa ragione è ben desiderabile che un sistema per la riproduzione del suono produca un’immagine coincidente nella posizione con quella visiva.

Sulla carta non è difficile ottenere un tal risultato, collocando i diffusori nelle immediate vicinanze del luogo d’evento. Purtroppo, nei siti caratterizzati da una cattiva acustica o da aree d’ascolto lunghe strette o da entrambe, come le navate di una chiesa, questa posizione dei trasduttori non consente una buona intelligibilità della parola o qualità del suono. Per ottenerle, occorre collocare i diffusori nei pressi degli ascoltatori, distruggendo la coerenza tra immagine visiva ed immagine sonora. È proprio quanto accade nella maggior parte dei siti attrezzati con un sistema di rinforzo sonoro. In molte sale per conferenza gli altoparlanti sono disposti nel controsoffitto. A tutta prima sembra che il suono, pur un poco vago, provenga dal podio del conferenziere. Poi, inesorabilmente, immagine e suono cominciano a dissociarsi e, alla fine, cominciamo a distrarci, a pensare ad altro anche se l’argomento è interessante e l’esposizione convincente… In chiesa, invece, non c’è rimedio. Se il suono proviene da una colonna alle nostre spalle o di lato, non v’è compensazione che tenga quando invece l‘officiante è di fronte a noi.

“… quello che l’occhio vede e l’orecchio sente, la mente crede.”

Per fortuna la ricerca e l’evoluzione tecnologica ci hanno regalato un modo per far coincidere suoni e immagini, pur originati in posizioni assai distanti tra loro. Il nostro sistema uditivo è molto più complicato e sofisticato di una coppia di microfoni perché gestito da un potente elaboratore: il cervello. La scienza che studia il modo con il quale la nostra mente interpreta le informazioni provenienti dalle orecchie è chiamata psicoacustica, e sono le ricerche in campo psicoacustico che hanno consentito di definire una regola, chiamata “Effetto Haas” molto importante per la localizzazione delle sorgenti sonore. La regola stabilisce che allorquando pervengono all’orecchio più segnali identici ma provenienti da direzioni diverse, il sistema uditivo determina come unica la direzione di provenienza del segnale primo arrivato, purché quelli successivi abbiamo intensità comparabile e ritardo non superiore a 40 ms. Questo effetto meglio si sintetizza con una curva di compatibilità (Figura 4) che definisce le ampiezze e i ritardi ammissibili per rientrare nei limiti dell’Effetto Haas.

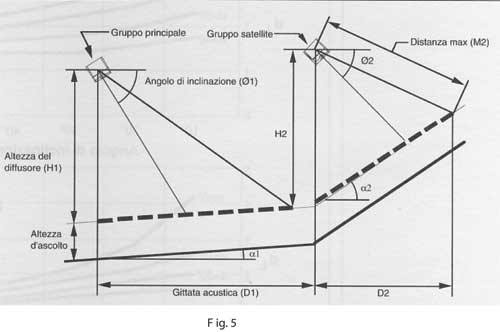

Per ottenere la corretta localizzazione del suono occorre creare un sistema di tipo ‘decentralizzato’, composto da un cluster centrale di diffusori, collocato, in prossimità della sede d’evento, e da uno o più anelli di diffusori scaglionati lungo l’area di ascolto (Figura 5). Questi ultimi sono alimentati con un segnale processato per mezzo di una linea di ritardo elettronica. Il ritardo impostato deve essere pari a quello impiegato dal suono per percorrere la distanza fra i diffusori principali e quelli dell’anello, aumentato di 15 millisecondi. Questo “offset” è necessario per sfruttare al meglio la curva di compatibilità, che appunto garantisce il miglior effetto quando il segnale ritardato arriva circa 15 ms dopo quello principale. Occorre anche rispettare i rapporti di ampiezza. Al di là delle analisi teoriche, la pratica ci suggerisce che, nel riprodurre la parola, il suono principale deve avere ampiezza non inferiore a ‑3 dB rispetto a quello secondario. Questo valore dipende fortemente dalla natura del suono: suoni impulsivi, come quelli di una batteria, sono molto più critici dei suoni continui, come quelli di un organo, e richiedono un valore d’ampiezza del segnale principale più elevato. In un sistema di questo tipo, i diffusori secondari, anche se vicini all’ascoltatore, paiono non funzionare affatto, ed è solo disattivando il cluster di diffusori principale che tornano ad essere ben udibili. Per contro, spegnendo i diffusori secondari il volume generale del suono e la localizzazione del suono variano di poco o nulla ma l’intelligibilità (o la qualità) del segnale calano drammaticamente.

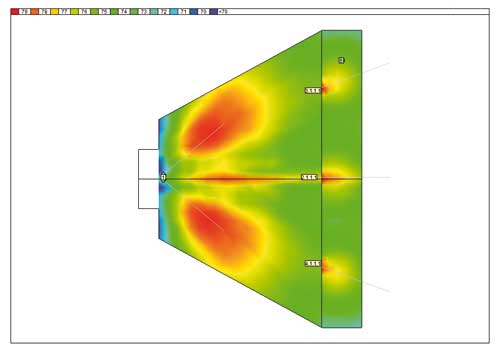

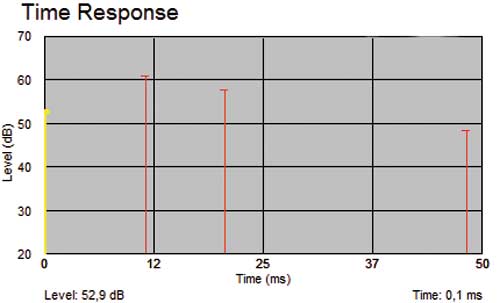

Altre regole importanti da rispettare sono la corretta distribuzione dei diffusori secondari, che devono coprire uniformemente l’area di ascolto (Figura 6), e l’impostazione del ritardo, tale da far rientrare l’emissione delle sorgenti, singolarmente e in gruppo, entro i limite della finestra di Haas (Figura 7). Tutti i diffusori, principali e secondari, devono essere orientati nella stessa direzione. In caso contrario, in alcune zone dell’area di ascolto non sarebbe garantita la corretta localizzazione, con il rischio di echi fastidiosi.

Da notare che la localizzazione si perpetua nei vari anelli di diffusori. In un impianto ben progettato, la sorgente principale continua ad esser correttamente localizzata anche ad una distanza di centinaia di metri – e molti anelli – dal cluster principale, purché questo abbia un’emissione consistente o quantomeno l‘abbia l’anello di diffusori precedente.

I vantaggi qualitativi di un sistema decentralizzato sono molto evidenti e certo non occorre enfatizzarli. Come sempre, ci sono anche le spine:

• Il DSP aggiuntivo e il maggior numero di amplificatori necessari producono un certo aumento dei costi, talvolta non compatibile con i budget limitati

• in ambienti con un’acustica molto sfavorevole (T60>7 ÷ 8 s) la localizzazione comporta una lieve diminuzione dell’intelligibilità, in genere compresa tra il 5 e il 15%.

• Il sistema deve essere costantemente monitorato e mantenuto. Non v’è nulla di più sconfortante di un sistema costoso, ben progettato ed installato che produce un suono cacofonico perché, con il tempo, l’utente o un “manutentore” inesperto hanno manomesso alcune apparecchiature o, semplicemente, trascurano di accenderle. Come, purtroppo, spesso avviene.

Sta all’installatore accorto il saper proporre ad un utente il sistema più adatto alle sue esigenze e possibilità.